Съдържание

- Дефиниция на SQL на Hadoop

- Как работи SQL на Hadoop?

- Основни предимства на SQL на Hadoop

- Сега повече хора могат да имат достъп до Hadoop

- Анализът на големи данни с Hadoop вече е по-прост

- Без грешки, без стрес - Вашето стъпка по стъпка ръководство за създаване на софтуер, променящ живота, без да разрушава живота ви

- Друга перспектива за SQL на Hadoop

- заключение

Източник: Maciek905 / Dreamstime.com

За вкъщи:

SQL на Hadoop комбинира тези два метода за управление на данни, за да образува нов инструмент за анализиране на данни.

SQL on Hadoop е група от инструменти за аналитични приложения, които съчетават заявки в SQL стил и обработка на данни с най-новите елементи на рамката за данни на Hadoop. Появата на SQL на Hadoop е важно развитие за обработката на големи данни, защото позволява на по-широки групи хора да работят успешно с рамката за обработка на данни на Hadoop, като пускат SQL заявки върху огромния обем големи данни, които Hadoop обработва. Очевидно рамката Hadoop преди това не е била толкова достъпна за хората, особено по отношение на възможностите за запитвания. Въз основа на разработката са разработени няколко инструмента, които обещават да подобрят производителността на предприятията, когато става въпрос за обработка и анализ на големи данни с качество и бързина. Също така не е необходимо да инвестирате много в изучаването на инструмента, както трябва да правят традиционните познания на SQL.

Дефиниция на SQL на Hadoop

SQL on Hadoop е група приложения, която ви позволява да стартирате заявки в стил SQL на големи данни, хоствани от рамката за обработка на данни Hadoop. Очевидно заявките, извличането и анализа на данни са станали по-лесни с добавянето на SQL на Hadoop. Тъй като първоначално SQL е проектиран за релационни бази данни, той трябваше да бъде модифициран според модела Hadoop 1, който включва MapReduce и разпределената файлова система Hadoop (HDFS) и модела Hadoop 2, който няма MapReduce и HDFS.

Едно от най-ранните усилия за комбиниране на SQL с Hadoop доведе до създаването на хранилището на данни Hive със софтуера HiveQL, който да превежда заявки в стил SQL в задания на MapReduce. След това бяха разработени няколко приложения, които могат да вършат подобна работа. Изтъкнати сред по-късните инструменти са Drill, BigSQL, HAWQ, Impala, Hadapt, Stinger, H-SQL, Splice Machine, Presto, PolyBase, Spark, JethroData, Shark (Hive on Spark) и Tez (Hive on Tez).

Как работи SQL на Hadoop?

SQL на Hadoop работи с Hadoop по следните начини:

- Съединителите в среда Hadoop превеждат SQL заявката във формат MapReduce, така че Hadoop разбира заявката.

- Pushdown системите изпълняват SQL заявката в кластерите Hadoop.

- Системите разделят огромния обем SQL заявки между MapReduce-HDFS клъстери в зависимост от натовареността на клъстерите.

Изглежда, че SQL заявката не променя своята същност; именно Hadoop адаптира заявката във формат, който тя разбира.

Основни предимства на SQL на Hadoop

Както вече беше посочено, SQL на Hadoop е важно развитие в контекста на това да направи анализа на големите данни достъпни за повече хора и да направи анализа на данните по-лесен и по-бърз. Няма съмнение, че рамката за данни Hadoop е чудесен инструмент за анализ на големи данни, но все още е достъпна само от ограничена група хора, не само поради огромните усилия, необходими за научаване на уникалната й архитектура, но и защото има проблеми със съвместимостта с други технологии. SQL на Hadoop обещава да реши тези проблеми.

Сега повече хора могат да имат достъп до Hadoop

Изглежда, че SQL на Hadoop направи Hadoop по-егалитарен в смисъл, че по-широки групи от хора вече могат да използват Hadoop за обработка и анализ на данни. По-рано, за да използвате Hadoop, трябваше да имате познания за архитектурата на Hadoop - MapReduce, Hadoop разпределена файлова система или HBase. Сега можете да включите почти всеки инструмент за анализ или отчитане и да получите достъп и анализирате данните.Благодарение на SQL на Hadoop, редица SQL на Hadoop двигатели като Cloudera Impala, Concurrent Lingual, Hadapt, CitusDB, InfiniDB, MammothDB, MemSQL, Pivotal HAWQ, Apache Drill, ScleraDB, Progress DataDirect, Simba и Splice Machine вече са в търговската мрежа. за използване с големи данни. Очевидно това е отворило Hadoop за по-широка аудитория, която вече може да очаква да увеличи възвръщаемостта на инвестициите си в големи данни.

Анализът на големи данни с Hadoop вече е по-прост

Сега всичко, което трябва да направите, е да стартирате добрата стара SQL заявка на големите данни, за да извлечете и анализирате данни. SQL се е развил от просто инструмент за релационна база данни до голям инструмент за анализ на данни, което наистина е значителна промяна. Не е нужно да се притеснявате как Hadoop обработва заявките - той има свой собствен начин за интерпретация на SQL заявките и ви дава резултатите. Експертите смятат, че въпреки че разпределената файлова система Hadoop има паралелна обработка на стокови клъстери за големи данни, тя може да подобри възможностите си за обработка, ако работи с интерактивни заявки в стил SQL. Преди HDFS да се комбинира със SQL, ще отнеме много време за обработка на данни с HDFS и задачата изисква специализирани учени по данни. И заявките не бяха интерактивни. С рамката Apache Tez, която се състои от аналитичен двигател Spark и интерактивен ускорител на запитвания Stinger за склада на данни на Hive, тези проблеми бяха решени. Според Ану Джайн, груповия мениджър на стратегия и архитектура в Търговската корпорация на дребно, „За нас е много важно да гарантираме, че предоставяме на потребителите интерактивен достъп до заявки. С Tez ние сме в състояние да предоставим тази възможност на бизнеса. "

Без грешки, без стрес - Вашето стъпка по стъпка ръководство за създаване на софтуер, променящ живота, без да разрушава живота ви

Не можете да подобрите уменията си за програмиране, когато никой не се интересува от качеството на софтуера.

Популярността на интерактивната анализа нараства сред потребителите на Hadoop, както показва проучване на Gartner. Според проучването 32% от анкетираните използват интерфейси на трети страни с HDFS или HBase, 27% използват самостоятелно създадени заявки чрез Hive, докато 23% използват специфични за разпространението Hadoop инструменти като Cloudera Impala и Pivotal HAWQ.

Друга перспектива за SQL на Hadoop

Въпреки че изглежда, че SQL на Hadoop ще реши много проблеми, които имаме с Hadoop, има друга гледна точка, която вярва, че SQL може да има много проблеми, особено когато се комбинира с Hadoop. Според това мнение SQL може да не е толкова ефективен в крайна сметка като аналитичен инструмент, когато става въпрос за големи данни. Според потребителския панел на Hadoop Summit Джон Уилямс, SQL може да не е най-добрият аналитичен инструмент за работа с големи данни. Според Уилямс, който е старши вицепрезидент за операциите на платформата на TrueCar, който предлага на потребителите платформа за закупуване на автомобили онлайн, „времето за изпълнение на SQL при голям набор от данни е бавно. Междувременно Hadoop в SQL става все по-бърз с неща като YARN и Tez. "

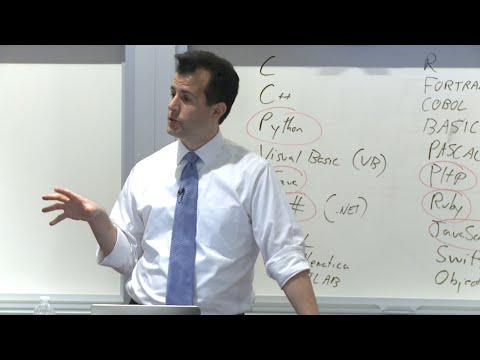

И това не е единственият проблем със SQL. Има много надземни задачи като проучване на данни, създаване на схеми, създаване на индекс и заявки и нормализиране, за което трябва да се погрижите, когато комбинирате SQL с Hadoop и може да отделите много време и усилия. След всички тези усилия няма гаранция, че сте извършили нещо постоянно. Ако нещо друго, с промените на приложението, може да се наложи да повторите това, което вече сте направили. Вместо SQL трябва да се извърши голямо фокусиране на данни на базата на Java и Python, тъй като тези езици са по-подходящи за неструктурирана обработка на данни.

заключение

Журито все още не е дали SQL в Hadoop е отговорът на проблемите на хората, изправени пред използването на Hadoop. Но ясно е, че индустрията се нуждае от по-добра алтернатива на собствените възможности за търсене на данни на Hadoop и тази алтернатива трябва да бъде интерактивна. SQL на Hadoop инструментите предоставят интерактивна аналитика, което е полезно. Предприятията не искат да губят време да се опитват да осмислят сложните, отнемащи време анализи. Засега предприятията намират SQL за Hadoop инструменти за много полезни.